游民星空 > > 正文

美国团队开发AI模型下毒工具:可保护画师艺术风格

2023-10-27 22:30:25 来源:游民星空 作者:不凹就沁丶优格 编辑:不凹就沁丶优格 浏览:loading

近日,芝加哥大学研究人员开发了一种新工具:它可以通过给图像数据“下毒”来防止艺术作品被喂给AI模型用于训练。

这个名为Nightshade的工具可以微调数字图像数据——人眼不可见,但会导致生成式训练模型(如 DALL-E、Midjourney 和 Stable Diffusion)出现各种故障。

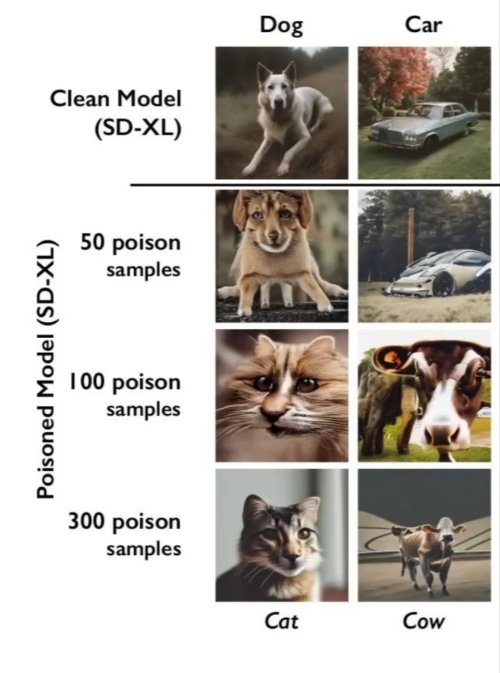

这种技术被其称为“数据毒化”,声称可以在训练时向AI引入“意外行为”。芝加哥大学团队表示,根据他们的研究论文,这种毒化攻击可以“出奇制胜”。目前对该技术的具体工作方式并未彻底公开,但大概是以人眼不可见的方式改变图像像素,同时导致机器学习模型导出错误内容。据称,毒化数据十分顽固,必须手动识别并把毒化图像从模型中一个个地删除。

研究人员使用Stable Diffusion作为测试对象,发现只需要300个毒化样本就可以使模型出错——认为一只狗是一只猫,或者认为一顶帽子是一个蛋糕。他们还表示,毒化图像的影响可能会扩展到相关概念(狗下面的哈士奇、比熊犬;帽子下面的牛仔帽、棒球帽)。

休闲娱乐

-

知名人士爆猛料!《生化危机》初代重制经典归来?

知名人士爆猛料!《生化危机》初代重制经典归来?

《忍龙4》DLC今日上线:超帅巨镰战斗拉满!

《忍龙4》DLC今日上线:超帅巨镰战斗拉满!

-

十几家工作室抢着做?《血源RE》内幕还有新料!

十几家工作室抢着做?《血源RE》内幕还有新料!

《宝可梦:火红/叶绿》测评:情怀热烈 质量一般!

《宝可梦:火红/叶绿》测评:情怀热烈 质量一般!

-

里昂个人秀!爆料称《生化9》DLC已接近完成

里昂个人秀!爆料称《生化9》DLC已接近完成

干点成年人该干的 从99%腿控变100%臀控的囧图

干点成年人该干的 从99%腿控变100%臀控的囧图

综合热点资讯

- 《三角洲》毁号主播认错求联系!私下言论再引舆论

- 女流66直播《生化9》离席喂奶5分钟 2万观众竟没走

- 《生化9》美女丧尸感染前后对比图 反差引玩家热议

- 卡普空官宣新发布会!时长30分钟 重点聚焦新作

- 《生化9》又一成人Mod公布!女主胸部超大超圆润

- 台湾男子吐槽撞人族是日本特有:就日本人干得出来

- 新疆姑娘拿下中国小姐冠军 这颜值如何!

- 疑似GTA6早期开发画面泄露!蓝天绿水和大桥

- 41岁打铁花网红意外去世 用剩炭取暖一氧化碳中毒

- 杨超越晒长腿美照 惊人的腿长和比例登热搜

单机游戏下载

- 《Alder Forge 2》官方正版下载

- 《风暴之桥》官方中文版下载

- 《KILL THE WITCH》官方中文版下载

- 《Radiance of Souls》官方正版下载

- 《Muffles' Life Sentence》官方正版下载

- 《Fallen Hero: Retribution》官方正版下载

- 《Hamachi the Psychotic Killer》官方正版下载

- 《凯恩的遗产:重制版》官方中文版下载

好物推荐

-

发布时间:2026-03-04

-

发布时间:2026-03-04

-

发布时间:2026-03-03

游民星空联运游戏