游民星空 > > 正文

不靠英伟达!华为原生模型比肩DeepSeek-R1!

2025-04-15 15:18:47 来源:IT之家 作者:汪淼 编辑:孤独时代的从心 浏览:loading

华为利用纯昇腾集群训练出的盘古 Ultra,在数学竞赛、编程等推理任务当中,和DeepSeek-R1打得有来有回。关键是模型参数量只有135B,整个训练过程零英伟达含量,而且没有出现损失尖峰。

通过改进的模型架构和系统优化策略,盘古 Ultra 拥有优异的性能表现和 52% 以上的算力利用率。并且有网友表示,训练过程中没有出现损失尖峰这一特征,似乎此前从未实现。

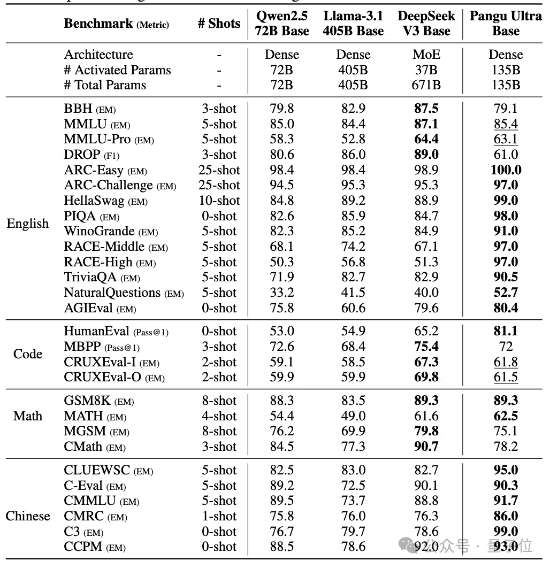

在预训练阶段模型的评测中,盘古 Ultra在绝大部分英文基准任务和全部中文任务上取得了最佳性能,优于Llama 405B、DeepSeek-V3等baseline模型。

尤其在MMLU、TriviaQA、GSM8K等具有挑战性的数据集上,盘古 Ultra展现出了卓越的语言理解和推理能力。

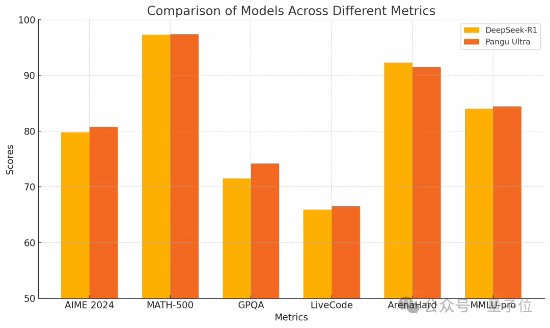

经过指令调优后,盘古 Ultra 的性能进一步提升,尤其在AIME 2024、MATH-500等数学推理任务和 LiveCodeBench 等编程竞赛题上达到了 SOTA 水平。同时,盘古 Ultra在Arena Hard、MMLU-pro等涵盖通用语言理解和推理的评测中也表现优异。

综合来看,盘古 Ultra超越了包括GPT-4o、Mistral-Large 2等强大模型,与DeepSeek-R1等MoE 模型竞争激烈。

休闲娱乐

-

同款onlyfans博主 拉开胸拍照才会冷的囧图

同款onlyfans博主 拉开胸拍照才会冷的囧图

低保户买NS2还公开炫耀?当事人怒吼:游戏是必需品!

低保户买NS2还公开炫耀?当事人怒吼:游戏是必需品!

-

PS大作女主被“爆改”性感女神 外貌争议再起?

PS大作女主被“爆改”性感女神 外貌争议再起?

《地平线6》日本战役细节曝光:竞速探索全都要!

《地平线6》日本战役细节曝光:竞速探索全都要!

-

光荣特库摩官宣大重组!《仁王3》开发商遭拆分

光荣特库摩官宣大重组!《仁王3》开发商遭拆分

NS2版《生化7》M站84分:原生运行效果惊艳!

NS2版《生化7》M站84分:原生运行效果惊艳!

综合热点资讯

- 腾讯关闭天美蒙特利尔工作室!成立5年没有自己作品

- 36斤活羊烤完只剩6.9斤引争议 商家称属正常损耗

- 《夜王》女神黄洁琪试镜超低胸战衣:大雷浑圆饱满

- 游戏女主播曝抖音直播内幕!播游戏没工资 真会饿死

- 日本一寺庙举办年度裸祭 万人争抢"宝木"致6人送医

- 男子聚餐后体内滤出7斤油 当场吓懵:这么一大袋

- kun哥再发力!PS+3月会免领衔大作揭晓

- 真正的冻龄女神!53岁李冰冰晒滑雪美照:状态杀疯了

- 三上悠亚发性感新照!大白美腿配超诱惑姿势

- 霉霉公开热门单曲录制幕后素颜照 网友:这有点吓人

单机游戏下载

- 《Check In Check Out》官方正版下载

- 《Gem Defender》官方正版下载

- 《魔法师世界Re;Try》官方中文版下载

- 《Scaling Up》官方正版下载

- 《Gargadusa's Tower》官方正版下载

- 《战锤40K:战区》官方中文版下载

- 《Breezy Bakes Simulator》官方中文版下载

- 《Gumball in Trick-or-Treat Land》官方正版下载

好物推荐

-

发布时间:2026-02-25

-

发布时间:2026-02-25

-

发布时间:2026-02-25

游民星空联运游戏