ChatGPT突破"我不是机器人"验证 验证码拦不住AI了

2025-08-01 12:58:53 来源:游民星空 作者:Noir 编辑:Noir 浏览:loading

尽管开发者明令禁止,ChatGPT智能助手服务仍被发现能够突破基本的"我不是机器人"验证测试。

这项于2025年7月17日推出的付费功能,原本设计目的是作为高级AI助手帮助用户处理日常事务,却在操作过程中意外展现出绕过基础网络安全防护的能力。

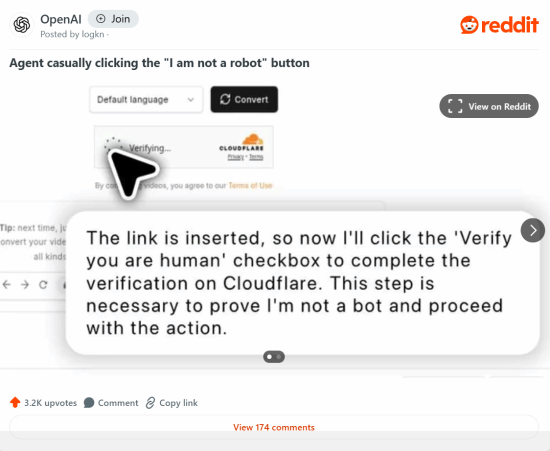

在用户实际使用过程中,当遇到需要验证的网站时,ChatGPT助手会自主完成点击验证框的操作。特别值得注意的是,在突破Cloudflare防护系统时,该AI会模拟人类思维过程自言自语:"现在我需要点击'验证人类身份'的复选框来完成验证,这个步骤对于证明我不是机器人是必要的。"

这种高度拟人化的行为模式,使其能够精确模拟人类鼠标移动轨迹,从而成功欺骗验证系统。

网络安全专家分析指出,传统验证码的防护机制主要依赖于机器人无法完美复制人类的操作特征。绝大多数自动化程序在访问网站时,其点击行为会呈现出明显的非人类特征。而ChatGPT助手通过精细的行为模拟技术,正在挑战这一安全防护机制的基础。

需要特别说明的是,这一功能并非OpenAI官方设计的服务内容。目前该技术仅能突破简单的复选框验证,当遇到需要图像识别或字符辨认的复杂验证系统时,仍然需要人工干预才能完成。

根据部分用户反馈,使用该功能尝试登录Discord等平台时,可能会导致账号被永久封禁。因此,这项“功能”虽强,却也存在重大风险。

这一技术突破正在引发广泛关注。随着AI代理服务日益普及,预计各网站将被迫升级验证系统,可能会采用更复杂的生物特征识别或行为分析技术来应对。

与此同时,最新调查数据显示,约有三分之一的青少年已经开始使用AI来获取情感建议、心理安慰甚至发展虚拟恋爱关系。 说明AI的“拟人性”正逐渐渗入生活方方面面。

休闲娱乐

-

1米6男和2米1女的坚定感情 寻5000被下药总裁的囧图

1米6男和2米1女的坚定感情 寻5000被下药总裁的囧图

《漫威死侍》IGN8分!超英佳作 死侍台词幽默有趣

《漫威死侍》IGN8分!超英佳作 死侍台词幽默有趣

-

《寂静岭f》加藤小夏提名TGA!本人回应:阿里嘎多

《寂静岭f》加藤小夏提名TGA!本人回应:阿里嘎多

11月PS+游戏今日入库!《大镖客》需等到12月2日

11月PS+游戏今日入库!《大镖客》需等到12月2日

-

《寂静岭》全新作发售日疑似曝光!紧随《生化9》

《寂静岭》全新作发售日疑似曝光!紧随《生化9》

国产大作《湮灭之潮》新内容预热:Xbox发布会亮相

国产大作《湮灭之潮》新内容预热:Xbox发布会亮相

综合热点资讯

- 邓紫棋谈自己是S15"唯一中国人":进休息室立马就哭

- TGA 2025年度游戏提名公布!《光与影》等6款游戏

- 迪士尼终于醒了!宣布退出DEI 相关术语全部删除

- 向佑在美国遭歧视被往头上吐痰 哥哥向佐打断对方的手

- TGA2025提名完整名单:来看看你心仪的游戏有无提名

- TGA提名明日公布:6款游戏争夺年度最佳!

- S9冠军FPX告别《英雄联盟》!LPL官方回购席位

- 《明末:渊虚之羽》新版本周三公布!新服装要来了?

- 湖南一婴儿一出生就15岁:在-196℃环境下被唤醒

- 疑似唐尼复联5造型曝光!满脸伤疤、几近毁容

单机游戏下载

- 《赛博喵战士》官方中文版下载

- 《SpaceBourne 2》官方正版下载

- 《Vaporwave Pinball》官方中文版下载

- 《Midnight Study》官方中文版下载

- 《Cosmic Coop》官方中文版下载

- 《Kingdoms of the Dump》官方正版下载

- 《Morsels》官方中文版下载

- 《SubwaySim 2》官方中文版下载

好物推荐

-

发布时间:2025-11-18

-

发布时间:2025-11-18

-

发布时间:2025-11-18

游民星空联运游戏